数据库的基本原理

数据库/SQL

本文字数: 8.1k 阅读时长 ≈ 7 分钟

[TOC]

一、基础#

模式定义了数据如何存储、存储什么样的数据以及数据如何分解等信息,数据库和表都有模式。

主键的值不允许修改,也不允许复用(不能将已经删除的主键值赋给新数据行的主键)。

SQL(Structured Query Language),标准 SQL 由 ANSI 标准委员会管理,从而称为 ANSI SQL。各个 DBMS 都有自己的实现,如 PL/SQL、Transact-SQL 等。

SQL 语句不区分大小写,但是数据库表名、列名和值是否区分依赖于具体的 DBMS 以及配置。

SQL 支持以下三种注释:

1 | # 注释 |

数据库创建与使用:

1 | CREATE DATABASE test; |

二、创建表#

1 | CREATE TABLE mytable ( |

三、修改表#

添加列

1 | ALTER TABLE mytable |

删除列

1 | ALTER TABLE mytable |

删除表

1 | DROP TABLE mytable; |

四、插入#

普通插入

1 | INSERT INTO mytable(col1, col2) |

插入检索出来的数据

1 | INSERT INTO mytable1(col1, col2) |

将一个表的内容插入到一个新表

1 | CREATE TABLE newtable AS |

五、更新#

1 | UPDATE mytable |

六、删除#

1 | DELETE FROM mytable |

TRUNCATE TABLE 可以清空表,也就是删除所有行。

1 | TRUNCATE TABLE mytable; |

使用更新和删除操作时一定要用 WHERE 子句,不然会把整张表的数据都破坏。可以先用 SELECT 语句进行测试,防止错误删除。

七、查询#

DISTINCT#

相同值只会出现一次。它作用于所有列,也就是说所有列的值都相同才算相同。

1 | SELECT DISTINCT col1, col2 |

LIMIT#

限制返回的行数。可以有两个参数,第一个参数为起始行,从 0 开始;第二个参数为返回的总行数。

返回前 5 行:

1 | SELECT * |

1 | SELECT * |

返回第 3 ~ 5 行:

1 | SELECT * |

八、排序#

- ASC :升序(默认)

- DESC :降序

可以按多个列进行排序,并且为每个列指定不同的排序方式:

1 | SELECT * |

九、过滤#

不进行过滤的数据非常大,导致通过网络传输了多余的数据,从而浪费了网络带宽。因此尽量使用 SQL 语句来过滤不必要的数据,而不是传输所有的数据到客户端中然后由客户端进行过滤。

1 | SELECT * |

下表显示了 WHERE 子句可用的操作符

| 操作符 | 说明 |

|---|---|

| = | 等于 |

| < | 小于 |

| > | 大于 |

| <> != | 不等于 |

| <= !> | 小于等于 |

| >= !< | 大于等于 |

| BETWEEN | 在两个值之间 |

| IS NULL | 为 NULL 值 |

应该注意到,NULL 与 0、空字符串都不同。

AND 和 OR 用于连接多个过滤条件。优先处理 AND,当一个过滤表达式涉及到多个 AND 和 OR 时,可以使用 () 来决定优先级,使得优先级关系更清晰。

IN 操作符用于匹配一组值,其后也可以接一个 SELECT 子句,从而匹配子查询得到的一组值。

NOT 操作符用于否定一个条件。

十、通配符#

通配符也是用在过滤语句中,但它只能用于文本字段。

% 匹配 >=0 个任意字符;

_ 匹配 ==1 个任意字符;

[ ] 可以匹配集合内的字符,例如 [ab] 将匹配字符 a 或者 b。用脱字符 ^ 可以对其进行否定,也就是不匹配集合内的字符。

使用 Like 来进行通配符匹配。

1 | SELECT * |

不要滥用通配符,通配符位于开头处匹配会非常慢。

十一、计算字段#

在数据库服务器上完成数据的转换和格式化的工作往往比客户端上快得多,并且转换和格式化后的数据量更少的话可以减少网络通信量。

计算字段通常需要使用 AS 来取别名,否则输出的时候字段名为计算表达式。

1 | SELECT col1 * col2 AS alias |

CONCAT() 用于连接两个字段。许多数据库会使用空格把一个值填充为列宽,因此连接的结果会出现一些不必要的空格,使用 TRIM() 可以去除首尾空格。

1 | SELECT CONCAT(TRIM(col1), '(', TRIM(col2), ')') AS concat_col |

十二、函数#

各个 DBMS 的函数都是不相同的,因此不可移植,以下主要是 MySQL 的函数。

汇总#

| 函 数 | 说 明 |

|---|---|

| AVG() | 返回某列的平均值 |

| COUNT() | 返回某列的行数 |

| MAX() | 返回某列的最大值 |

| MIN() | 返回某列的最小值 |

| SUM() | 返回某列值之和 |

AVG() 会忽略 NULL 行。

使用 DISTINCT 可以汇总不同的值。

1 | SELECT AVG(DISTINCT col1) AS avg_col |

文本处理#

| 函数 | 说明 |

|---|---|

| LEFT() | 左边的字符 |

| RIGHT() | 右边的字符 |

| LOWER() | 转换为小写字符 |

| UPPER() | 转换为大写字符 |

| LTRIM() | 去除左边的空格 |

| RTRIM() | 去除右边的空格 |

| LENGTH() | 长度 |

| SOUNDEX() | 转换为语音值 |

其中, SOUNDEX() 可以将一个字符串转换为描述其语音表示的字母数字模式。

1 | SELECT * |

日期和时间处理#

- 日期格式:YYYY-MM-DD

- 时间格式:HH:

MM:SS

| 函 数 | 说 明 |

|---|---|

| ADDDATE() | 增加一个日期(天、周等) |

| ADDTIME() | 增加一个时间(时、分等) |

| CURDATE() | 返回当前日期 |

| CURTIME() | 返回当前时间 |

| DATE() | 返回日期时间的日期部分 |

| DATEDIFF() | 计算两个日期之差 |

| DATE_ADD() | 高度灵活的日期运算函数 |

| DATE_FORMAT() | 返回一个格式化的日期或时间串 |

| DAY() | 返回一个日期的天数部分 |

| DAYOFWEEK() | 对于一个日期,返回对应的星期几 |

| HOUR() | 返回一个时间的小时部分 |

| MINUTE() | 返回一个时间的分钟部分 |

| MONTH() | 返回一个日期的月份部分 |

| NOW() | 返回当前日期和时间 |

| SECOND() | 返回一个时间的秒部分 |

| TIME() | 返回一个日期时间的时间部分 |

| YEAR() | 返回一个日期的年份部分 |

1 | mysql> SELECT NOW(); |

1 | 2018-4-14 20:25:11 |

数值处理#

| 函数 | 说明 |

|---|---|

| SIN() | 正弦 |

| COS() | 余弦 |

| TAN() | 正切 |

| ABS() | 绝对值 |

| SQRT() | 平方根 |

| MOD() | 余数 |

| EXP() | 指数 |

| PI() | 圆周率 |

| RAND() | 随机数 |

十三、分组#

把具有相同的数据值的行放在同一组中。

可以对同一分组数据使用汇总函数进行处理,例如求分组数据的平均值等。

指定的分组字段除了能按该字段进行分组,也会自动按该字段进行排序。

1 | SELECT col, COUNT(*) AS num |

GROUP BY 自动按分组字段进行排序,ORDER BY 也可以按汇总字段来进行排序。

1 | SELECT col, COUNT(*) AS num |

WHERE 过滤行,HAVING 过滤分组,行过滤应当先于分组过滤。

1 | SELECT col, COUNT(*) AS num |

分组规定:

- GROUP BY 子句出现在 WHERE 子句之后,ORDER BY 子句之前;

- 除了汇总字段外,SELECT 语句中的每一字段都必须在 GROUP BY 子句中给出;

- NULL 的行会单独分为一组;

- 大多数 SQL 实现不支持 GROUP BY 列具有可变长度的数据类型。

十四、子查询#

子查询中只能返回一个字段的数据。

可以将子查询的结果作为 WHRER 语句的过滤条件:

1 | SELECT * |

下面的语句可以检索出客户的订单数量,子查询语句会对第一个查询检索出的每个客户执行一次:

1 | SELECT cust_name, (SELECT COUNT(*) |

十五、连接#

连接用于连接多个表,使用 JOIN 关键字,并且条件语句使用 ON 而不是 WHERE。

连接可以替换子查询,并且比子查询的效率一般会更快。

可以用 AS 给列名、计算字段和表名取别名,给表名取别名是为了简化 SQL 语句以及连接相同表。

内连接#

内连接又称等值连接,使用 INNER JOIN 关键字。

1 | SELECT A.value, B.value |

可以不明确使用 INNER JOIN,而使用普通查询并在 WHERE 中将两个表中要连接的列用等值方法连接起来。

1 | SELECT A.value, B.value |

自连接#

自连接可以看成内连接的一种,只是连接的表是自身而已。

一张员工表,包含员工姓名和员工所属部门,要找出与 Jim 处在同一部门的所有员工姓名。

子查询版本

1 | SELECT name |

自连接版本

1 | SELECT e1.name |

自然连接#

自然连接是把同名列通过等值测试连接起来的,同名列可以有多个。

内连接和自然连接的区别:内连接提供连接的列,而自然连接自动连接所有同名列。

1 | SELECT A.value, B.value |

外连接#

外连接保留了没有关联的那些行。分为左外连接,右外连接以及全外连接,左外连接就是保留左表没有关联的行。

检索所有顾客的订单信息,包括还没有订单信息的顾客。

1 | SELECT Customers.cust_id, Orders.order_num |

customers 表:

| cust_id | cust_name |

|---|---|

| 1 | a |

| 2 | b |

| 3 | c |

orders 表:

| order_id | cust_id |

|---|---|

| 1 | 1 |

| 2 | 1 |

| 3 | 3 |

| 4 | 3 |

结果:

| cust_id | cust_name | order_id |

|---|---|---|

| 1 | a | 1 |

| 1 | a | 2 |

| 3 | c | 3 |

| 3 | c | 4 |

| 2 | b | Null |

十六、组合查询#

使用 UNION 来组合两个查询,如果第一个查询返回 M 行,第二个查询返回 N 行,那么组合查询的结果一般为 M+N 行。

每个查询必须包含相同的列、表达式和聚集函数。

默认会去除相同行,如果需要保留相同行,使用 UNION ALL。

只能包含一个 ORDER BY 子句,并且必须位于语句的最后。

1 | SELECT col |

十七、视图#

视图是虚拟的表,本身不包含数据,也就不能对其进行索引操作。

对视图的操作和对普通表的操作一样。

视图具有如下好处:

- 简化复杂的 SQL 操作,比如复杂的连接;

- 只使用实际表的一部分数据;

- 通过只给用户访问视图的权限,保证数据的安全性;

- 更改数据格式和表示。

1 | CREATE VIEW myview AS |

十八、存储过程#

存储过程可以看成是对一系列 SQL 操作的批处理。

使用存储过程的好处:

- 代码封装,保证了一定的安全性;

- 代码复用;

- 由于是预先编译,因此具有很高的性能。

命令行中创建存储过程需要自定义分隔符,因为命令行是以 ; 为结束符,而存储过程中也包含了分号,因此会错误把这部分分号当成是结束符,造成语法错误。

包含 in、out 和 inout 三种参数。

给变量赋值都需要用 select into 语句。

每次只能给一个变量赋值,不支持集合的操作。

1 | delimiter // |

1 | call myprocedure(@ret); |

十九、游标#

在存储过程中使用游标可以对一个结果集进行移动遍历。

游标主要用于交互式应用,其中用户需要对数据集中的任意行进行浏览和修改。

使用游标的四个步骤:

- 声明游标,这个过程没有实际检索出数据;

- 打开游标;

- 取出数据;

- 关闭游标;

1 | delimiter // |

二十、触发器#

触发器会在某个表执行以下语句时而自动执行:DELETE、INSERT、UPDATE。

触发器必须指定在语句执行之前还是之后自动执行,之前执行使用 BEFORE 关键字,之后执行使用 AFTER 关键字。BEFORE 用于数据验证和净化,AFTER 用于审计跟踪,将修改记录到另外一张表中。

INSERT 触发器包含一个名为 NEW 的虚拟表。

1 | CREATE TRIGGER mytrigger AFTER INSERT ON mytable |

DELETE 触发器包含一个名为 OLD 的虚拟表,并且是只读的。

UPDATE 触发器包含一个名为 NEW 和一个名为 OLD 的虚拟表,其中 NEW 是可以被修改的,而 OLD 是只读的。

MySQL 不允许在触发器中使用 CALL 语句,也就是不能调用存储过程。

二十一、事务管理#

基本术语:

- 事务(transaction)指一组 SQL 语句;

- 回退(rollback)指撤销指定 SQL 语句的过程;

- 提交(commit)指将未存储的 SQL 语句结果写入数据库表;

- 保留点(savepoint)指事务处理中设置的临时占位符(placeholder),你可以对它发布回退(与回退整个事务处理不同)。

不能回退 SELECT 语句,回退 SELECT 语句也没意义;也不能回退 CREATE 和 DROP 语句。

MySQL 的事务提交默认是隐式提交,每执行一条语句就把这条语句当成一个事务然后进行提交。当出现 START TRANSACTION 语句时,会关闭隐式提交;当 COMMIT 或 ROLLBACK 语句执行后,事务会自动关闭,重新恢复隐式提交。

设置 autocommit 为 0 可以取消自动提交;autocommit 标记是针对每个连接而不是针对服务器的。

如果没有设置保留点,ROLLBACK 会回退到 START TRANSACTION 语句处;如果设置了保留点,并且在 ROLLBACK 中指定该保留点,则会回退到该保留点。

1 | START TRANSACTION |

二十二、字符集#

基本术语:

- 字符集为字母和符号的集合;

- 编码为某个字符集成员的内部表示;

- 校对字符指定如何比较,主要用于排序和分组。

除了给表指定字符集和校对外,也可以给列指定:

1 | CREATE TABLE mytable |

可以在排序、分组时指定校对:

1 | SELECT * |

二十三、权限管理#

MySQL 的账户信息保存在 mysql 这个数据库中。

1 | USE mysql; |

创建账户

新创建的账户没有任何权限。

1 | CREATE USER myuser IDENTIFIED BY 'mypassword'; |

修改账户名

1 | RENAME myuser TO newuser; |

删除账户

1 | DROP USER myuser; |

查看权限

1 | SHOW GRANTS FOR myuser; |

授予权限

账户用 username@host 的形式定义,username@% 使用的是默认主机名。

1 | GRANT SELECT, INSERT ON mydatabase.* TO myuser; |

删除权限

GRANT 和 REVOKE 可在几个层次上控制访问权限:

- 整个服务器,使用 GRANT ALL 和 REVOKE ALL;

- 整个数据库,使用 ON database.*;

- 特定的表,使用 ON database.table;

- 特定的列;

- 特定的存储过程。

1 | REVOKE SELECT, INSERT ON mydatabase.* FROM myuser; |

更改密码

必须使用 Password() 函数进行加密。

1 | SET PASSWROD FOR myuser = Password('new_password'); |

参考资料#

- BenForta. SQL 必知必会 [M]. 人民邮电出版社, 2013.

更多精彩内容将发布在公众号 CyC2018,公众号提供了该项目的离线阅读版本,后台回复”下载” 即可领取。也提供了一份技术面试复习思维导图,不仅系统整理了面试知识点,而且标注了各个知识点的重要程度,从而帮你理清多而杂的面试知识点,后台回复”资料” 即可领取。我基本是按照这个思维导图来进行复习的,对我拿到了 BAT 头条等 Offer 起到很大的帮助。你们完全可以和我一样根据思维导图上列的知识点来进行复习,就不用看很多不重要的内容,也可以知道哪些内容很重要从而多安排一些复习时间。

数据库/Redis

本文字数: 11k 阅读时长 ≈ 10 分钟

- 一、概述

- 二、数据类型

- 三、数据结构

- 四、使用场景

- 五、Redis 与 Memcached

- 六、键的过期时间

- 七、数据淘汰策略

- 八、持久化

- 九、事务

- 十、事件

- 十一、复制

- 十二、Sentinel

- 十三、分片

- 十四、一个简单的论坛系统分析

- 参考资料

一、概述#

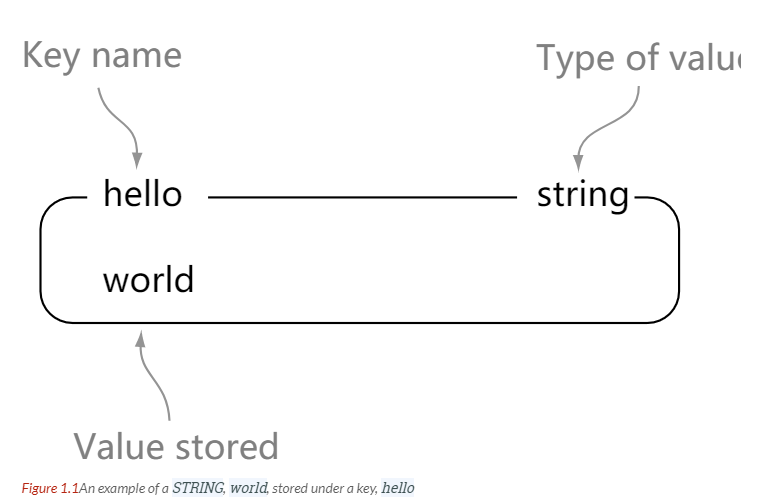

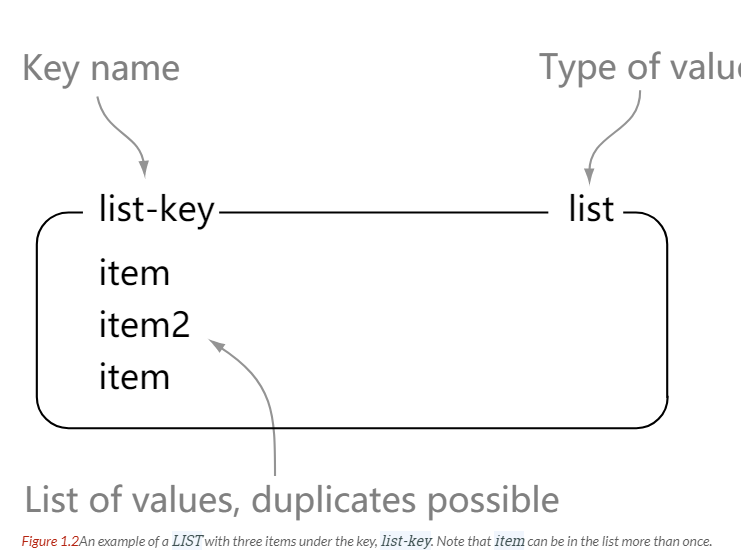

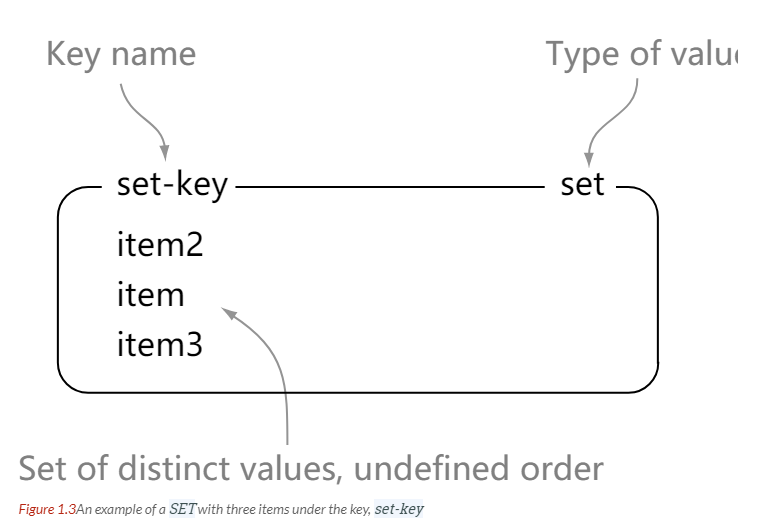

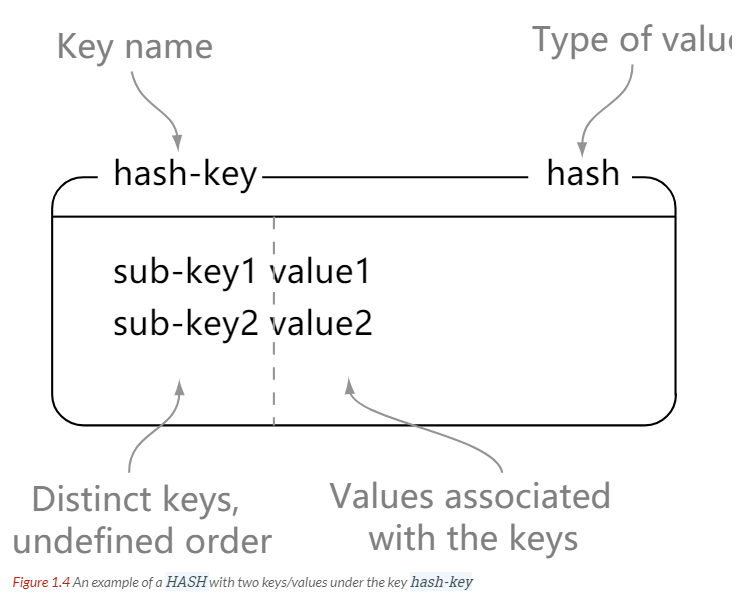

Redis 是速度非常快的非关系型(NoSQL)内存键值数据库,可以存储键和五种不同类型的值之间的映射。

键的类型只能为字符串,值支持五种数据类型:字符串、列表、集合、散列表、有序集合。

Redis 支持很多特性,例如将内存中的数据持久化到硬盘中,使用复制来扩展读性能,使用分片来扩展写性能。

二、数据类型#

| 数据类型 | 可以存储的值 | 操作 |

|---|---|---|

| STRING | 字符串、整数或者浮点数 | 对整个字符串或者字符串的其中一部分执行操作 对整数和浮点数执行自增或者自减操作 |

| LIST | 列表 | 从两端压入或者弹出元素 对单个或者多个元素 进行修剪,只保留一个范围内的元素 |

| SET | 无序集合 | 添加、获取、移除单个元素 检查一个元素是否存在于集合中 计算交集、并集、差集 从集合里面随机获取元素 |

| HASH | 包含键值对的无序散列表 | 添加、获取、移除单个键值对 获取所有键值对 检查某个键是否存在 |

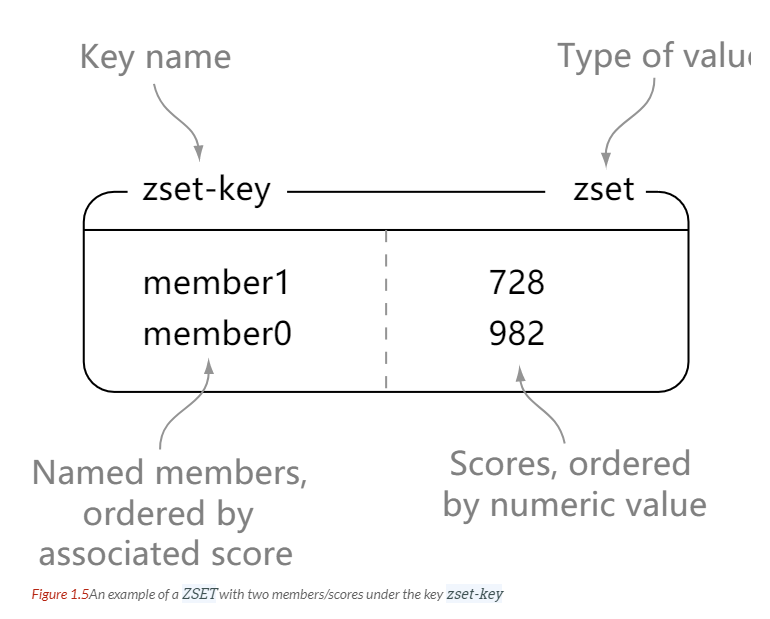

| ZSET | 有序集合 | 添加、获取、删除元素 根据分值范围或者成员来获取元素 计算一个键的排名 |

STRING#

1 | > set hello world |

LIST#

1 | > rpush list-key item |

SET#

1 | > sadd set-key item |

HASH#

1 | > hset hash-key sub-key1 value1 |

ZSET#

1 | > zadd zset-key 728 member1 |

三、数据结构#

SDS#

SDS是Redis中用于替代char*的数据结构,定义如下:

1 |

|

注意buf中的数据仍然以’\0’结尾,但是len的长度不包含这个字符,因此buf的实际长度因该是len+1; 这样做的目的是为了重用c中对字符串操作的库函数。

SDS与C语言字符串的不同点:

sds能够通过len在常数时间复杂度内获取字符串长度。在C语言中需要遍历字符串才能获取长度。

避免缓冲区溢出。通过len检查内存空间长度,避免溢出。

减少字符串重新分配的次数。c中增加或减少长度的时候,只能重新分配内存,不然会导致缓冲区溢出(长度新增加)或内存泄漏(长度减小)。而sds通过len和free可以服用已分配的内存空间。

二进制安全。不使用’\0’作为字符串的结尾标志,而使用len。解释数据交给上层处理。

兼容部分C字符串处理函数。sds虽然不使’\0’表示字符串结尾,但是buf中任然会存储’\0’。因此兼容C中的字符串处理函数。

字典#

dictht 是一个散列表结构,使用拉链法保存哈希冲突。

1 | /* This is our hash table structure. Every dictionary has two of this as we |

1 | typedef struct dictEntry { |

Redis 的字典 dict 中包含两个哈希表 dictht,这是为了方便进行 rehash 操作。在扩容时,将其中一个 dictht 上的键值对 rehash 到另一个 dictht 上面,完成之后释放空间并交换两个 dictht 的角色。

1 | typedef struct dict { |

rehash 操作不是一次性完成,而是采用渐进方式,这是为了避免一次性执行过多的 rehash 操作给服务器带来过大的负担。

渐进式 rehash 通过记录 dict 的 rehashidx 完成,它从 0 开始,然后每执行一次 rehash 都会递增。例如在一次 rehash 中,要把 dict[0] rehash 到 dict[1],这一次会把 dict[0] 上 table[rehashidx] 的键值对 rehash 到 dict[1] 上,dict[0] 的 table[rehashidx] 指向 null,并令 rehashidx++。

在 rehash 期间,每次对字典执行添加、删除、查找或者更新操作时,都会执行一次渐进式 rehash。

采用渐进式 rehash 会导致字典中的数据分散在两个 dictht 上,因此对字典的查找操作也需要到对应的 dictht 去执行。

1 | /* Performs N steps of incremental rehashing. Returns 1 if there are still |

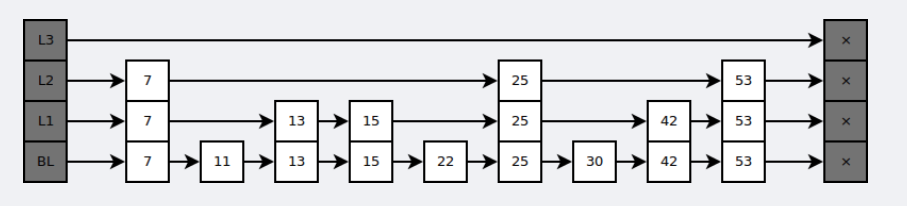

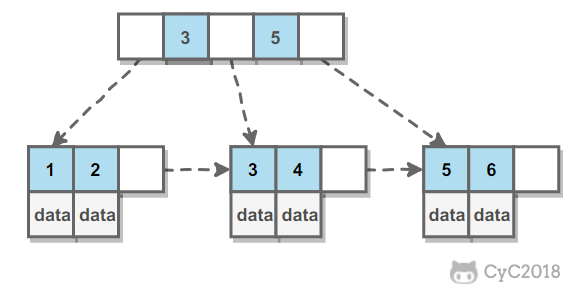

跳跃表#

是有序集合的底层实现之一。

跳跃表是基于多指针有序链表实现的,可以看成多个有序链表。

在查找时,从上层指针开始查找,找到对应的区间之后再到下一层去查找。下图演示了查找 22 的过程。

跳表与平衡树,哈希表的比较:

- skiplist和平衡树是有序的,而哈希表时无序的。因此哈希表不适合范围查找,skiplist和平衡树适合范围查找

- 在做范围查找时,平衡树的操作比skiplist更简单。skiplist做范围查询时只需要找到最小值,然后从这个值开始在最底层开始遍历即可。而平衡树还需要中序遍历其它节点。

- 插入和删除速度非常快速,因为不需要进行旋转等操作来维护平衡性;

- 更容易实现,skiplist比平衡树简单的多;

四、使用场景#

计数器#

可以对 String 进行自增自减运算,从而实现计数器功能。

Redis 这种内存型数据库的读写性能非常高,很适合存储频繁读写的计数量。

缓存#

将热点数据放到内存中,设置内存的最大使用量以及淘汰策略来保证缓存的命中率。

查找表#

例如 DNS 记录就很适合使用 Redis 进行存储。

查找表和缓存类似,也是利用了 Redis 快速的查找特性。但是查找表的内容不能失效,而缓存的内容可以失效,因为缓存不作为可靠的数据来源。

消息队列#

List 是一个双向链表,可以通过 lpush 和 rpop 写入和读取消息

不过最好使用 Kafka、RabbitMQ 等消息中间件。

会话缓存#

可以使用 Redis 来统一存储多台应用服务器的会话信息。

当应用服务器不再存储用户的会话信息,也就不再具有状态,一个用户可以请求任意一个应用服务器,从而更容易实现高可用性以及可伸缩性。

分布式锁实现#

在分布式场景下,无法使用单机环境下的锁来对多个节点上的进程进行同步。

可以使用 Redis 自带的 SETNX 命令实现分布式锁,除此之外,还可以使用官方提供的 RedLock 分布式锁实现。

其它#

Set 可以实现交集、并集等操作,从而实现共同好友等功能。

ZSet 可以实现有序性操作,从而实现排行榜等功能。

五、Redis 与 Memcached#

两者都是非关系型内存键值数据库,主要有以下不同:

数据类型#

Memcached 仅支持字符串类型,而 Redis 支持五种不同的数据类型,可以更灵活地解决问题。

数据持久化#

Redis 支持两种持久化策略:RDB 快照和 AOF 日志,而 Memcached 不支持持久化。

分布式#

Memcached 不支持分布式,只能通过在客户端使用一致性哈希来实现分布式存储,这种方式在存储和查询时都需要先在客户端计算一次数据所在的节点。

Redis Cluster 实现了分布式的支持。

内存管理机制#

- 在 Redis 中,并不是所有数据都一直存储在内存中,可以将一些很久没用的 value 交换到磁盘,而 Memcached 的数据则会一直在内存中。

- Memcached 将内存分割成特定长度的块来存储数据,以完全解决内存碎片的问题。但是这种方式会使得内存的利用率不高,例如块的大小为 128 bytes,只存储 100 bytes 的数据,那么剩下的 28 bytes 就浪费掉了。

线程处理方式#

- Redis使用单线程:

- Memcached基于多线程

六、键的过期策略#

Redis 可以为每个键设置过期时间,当键过期时,会自动删除该键。

对于散列表这种容器,只能为整个键设置过期时间(整个散列表),而不能为键里面的单个元素设置过期时间。

过期策略:定期删除+惰性删除

定期删除:每个100ms检查,是否有key过期,过期则删除。但是这个不会扫描所有数据,只会随机抽取数据进行检查。

惰性删除:获取某个key的时候,redis检查一下,如果过期了则会删除。

七、数据淘汰策略#

可以设置内存最大使用量,当内存使用量超出时,会施行数据淘汰策略。

Redis 具体有 6 种淘汰策略:

| 策略 | 描述 |

|---|---|

| volatile-lru | 从已设置过期时间的数据集中挑选最近最少使用的数据淘汰 |

| volatile-ttl | 从已设置过期时间的数据集中挑选将要过期的数据淘汰 |

| volatile-random | 从已设置过期时间的数据集中任意选择数据淘汰 |

| allkeys-lru | 从所有数据集中挑选最近最少使用的数据淘汰 |

| allkeys-random | 从所有数据集中任意选择数据进行淘汰 |

| noeviction | 禁止驱逐数据 |

作为内存数据库,出于对性能和内存消耗的考虑,Redis 的淘汰算法实际实现上并非针对所有 key,而是抽样一小部分并且从中选出被淘汰的 key。

使用 Redis 缓存数据时,为了提高缓存命中率,需要保证缓存数据都是热点数据。可以将内存最大使用量设置为热点数据占用的内存量,然后启用 allkeys-lru 淘汰策略,将最近最少使用的数据淘汰。

Redis 4.0 引入了 volatile-lfu 和 allkeys-lfu 淘汰策略,LFU 策略通过统计访问频率,将访问频率最少的键值对淘汰。

八、持久化#

Redis 是内存型数据库,为了保证数据在断电后不会丢失,需要将内存中的数据持久化到硬盘上。

RDB 持久化#

将某个时间点的所有数据都存放到硬盘上。

可以将快照复制到其它服务器从而创建具有相同数据的服务器副本。

如果系统发生故障,将会丢失最后一次创建快照之后的数据。

如果数据量很大,保存快照的时间会很长。

AOF 持久化#

将写命令添加到 AOF 文件(Append Only File)的末尾。

使用 AOF 持久化需要设置同步选项,从而确保写命令什么时候会同步到磁盘文件上。这是因为对文件进行写入并不会马上将内容同步到磁盘上,而是先存储到缓冲区,然后由操作系统决定什么时候同步到磁盘。有以下同步选项:

| 选项 | 同步频率 |

|---|---|

| always | 每个写命令都同步 |

| everysec | 每秒同步一次 |

| no | 让操作系统来决定何时同步 |

- always 选项会严重减低服务器的性能;

- everysec 选项比较合适,可以保证系统崩溃时只会丢失一秒左右的数据,并且 Redis 每秒执行一次同步对服务器性能几乎没有任何影响;

- no 选项并不能给服务器性能带来多大的提升,而且也会增加系统崩溃时数据丢失的数量。

随着服务器写请求的增多,AOF 文件会越来越大。Redis 提供了一种将 AOF 重写的特性,能够去除 AOF 文件中的冗余写命令。

九、事务#

一个事务包含了多个命令,服务器在执行事务期间,不会改去执行其它客户端的命令请求。

事务中的多个命令被一次性发送给服务器,而不是一条一条发送,这种方式被称为流水线,它可以减少客户端与服务器之间的网络通信次数从而提升性能。

Redis 最简单的事务实现方式是使用 MULTI 和 EXEC 命令将事务操作包围起来。

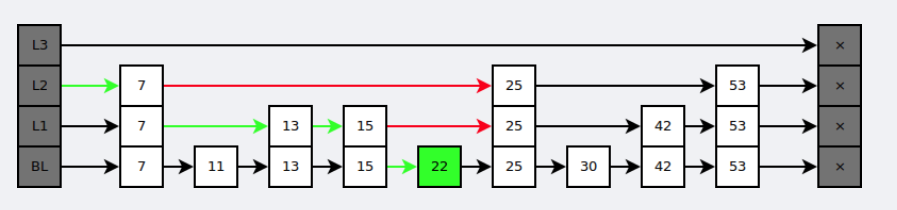

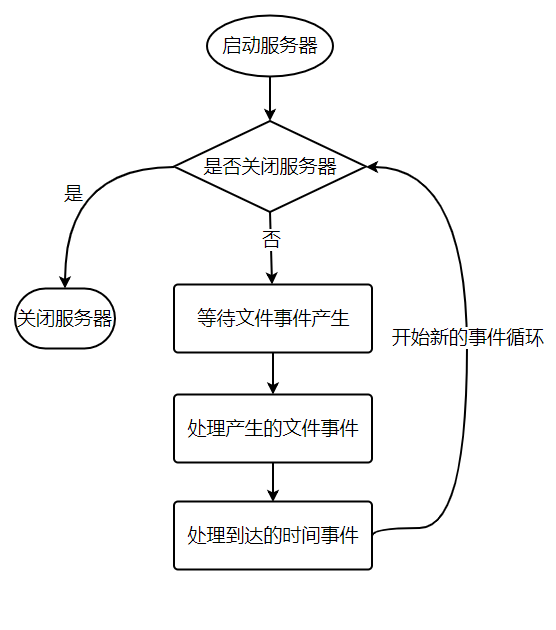

十、事件#

Redis 服务器是一个事件驱动程序。

文件事件#

服务器通过套接字与客户端或者其它服务器进行通信,文件事件就是对套接字操作的抽象。

Redis 基于 Reactor 模式开发了自己的网络事件处理器,使用 I/O 多路复用程序来同时监听多个套接字,并将到达的事件传送给文件事件分派器,分派器会根据套接字产生的事件类型调用相应的事件处理器。

## 时间事件

服务器有一些操作需要在给定的时间点执行,时间事件是对这类定时操作的抽象。

时间事件又分为:

- 定时事件:是让一段程序在指定的时间之内执行一次;

- 周期性事件:是让一段程序每隔指定时间就执行一次。

Redis 将所有时间事件都放在一个无序链表中,通过遍历整个链表查找出已到达的时间事件,并调用相应的事件处理器。

事件的调度与执行#

服务器需要不断监听文件事件的套接字才能得到待处理的文件事件,但是不能一直监听,否则时间事件无法在规定的时间内执行,因此监听时间应该根据距离现在最近的时间事件来决定。

事件调度与执行由 aeProcessEvents 函数负责,伪代码如下:

1 | def aeProcessEvents(): |

将 aeProcessEvents 函数置于一个循环里面,加上初始化和清理函数,就构成了 Redis 服务器的主函数,伪代码如下:

1 | def main(): |

从事件处理的角度来看,服务器运行流程如下:

# 十一、复制

通过使用 slaveof host port 命令来让一个服务器成为另一个服务器的从服务器。

一个从服务器只能有一个主服务器,并且不支持主主复制。

连接过程#

主服务器创建快照文件,发送给从服务器,并在发送期间使用缓冲区记录执行的写命令。快照文件发送完毕之后,开始向从服务器发送存储在缓冲区中的写命令;

从服务器丢弃所有旧数据,载入主服务器发来的快照文件,之后从服务器开始接受主服务器发来的写命令;

主服务器每执行一次写命令,就向从服务器发送相同的写命令。

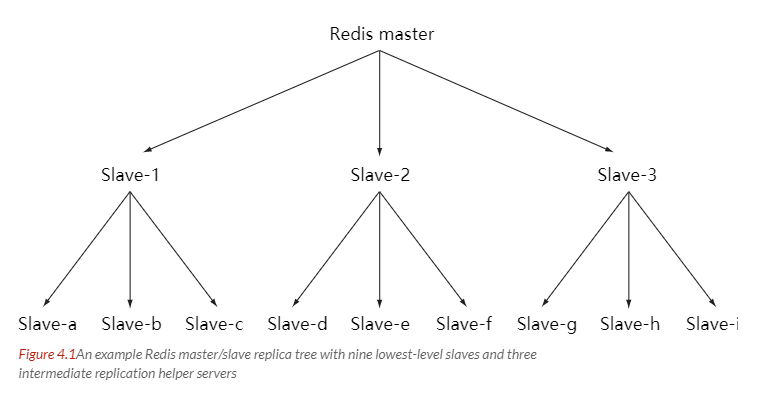

主从链#

随着负载不断上升,主服务器可能无法很快地更新所有从服务器,或者重新连接和重新同步从服务器将导致系统超载。为了解决这个问题,可以创建一个中间层来分担主服务器的复制工作。中间层的服务器是最上层服务器的从服务器,又是最下层服务器的主服务器。

# 十二、Sentinel

Sentinel(哨兵)可以监听集群中的服务器,并在主服务器进入下线状态时,自动从从服务器中选举出新的主服务器。

十三、分片#

分片是将数据划分为多个部分的方法,可以将数据存储到多台机器里面,这种方法在解决某些问题时可以获得线性级别的性能提升。

假设有 4 个 Redis 实例 R0,R1,R2,R3,还有很多表示用户的键 user:1,user:2,… ,有不同的方式来选择一个指定的键存储在哪个实例中。

- 最简单的方式是范围分片,例如用户 id 从 0~1000 的存储到实例 R0 中,用户 id 从 1001~2000 的存储到实例 R1 中,等等。但是这样需要维护一张映射范围表,维护操作代价很高。

- 还有一种方式是哈希分片,使用 CRC32 哈希函数将键转换为一个数字,再对实例数量求模就能知道应该存储的实例。

根据执行分片的位置,可以分为三种分片方式:

- 客户端分片:客户端使用一致性哈希等算法决定键应当分布到哪个节点。

- 代理分片:将客户端请求发送到代理上,由代理转发请求到正确的节点上。

- 服务器分片:Redis Cluster。

十四、缓存雪崩和缓存穿透#

缓存雪崩#

缓存雪崩指的是缓存同一时间大面积的失效,所以后面的请求都落到数据库上,造成数据库无法承受大量请求而崩溃。

解决办法:

- 缓存数据的过期时间设置随机,放置大量数据同时失效。

- 如果在分布式环境下,将热点数据均匀分布在不同的缓存数据库中。

- 设置热点数据永不失效

缓存穿透#

用户不断发起请求缓存和数据库中都没有的数据,此时的用户可能是攻击者,攻击会导致数据库压力过大。

解决方案:

接口层增加校验,如用户权限检查,ID基础校验等。

可以将数据库中不存在的数据在缓存中设置成null,避免同一个id的暴力攻击。

十四、一个简单的论坛系统分析#

该论坛系统功能如下:

- 可以发布文章;

- 可以对文章进行点赞;

- 在首页可以按文章的发布时间或者文章的点赞数进行排序显示。

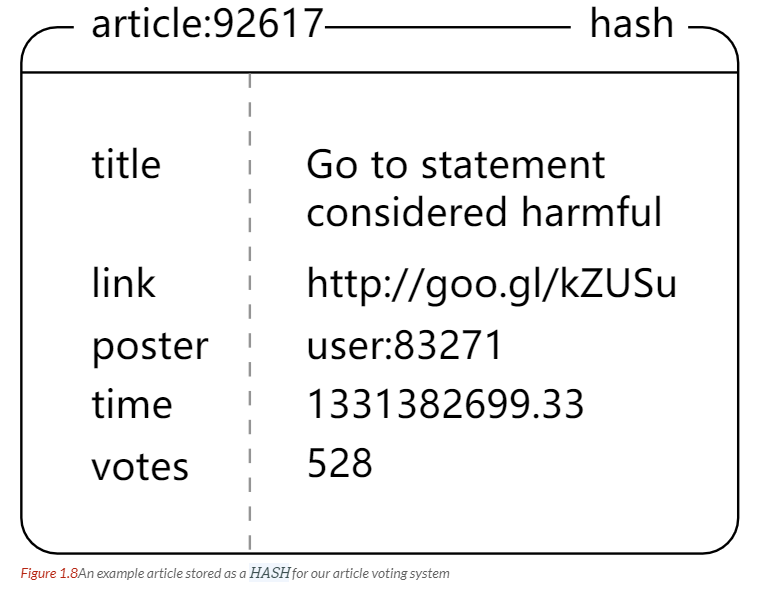

文章信息#

文章包括标题、作者、赞数等信息,在关系型数据库中很容易构建一张表来存储这些信息,在 Redis 中可以使用 HASH 来存储每种信息以及其对应的值的映射。

Redis 没有关系型数据库中的表这一概念来将同种类型的数据存放在一起,而是使用命名空间的方式来实现这一功能。键名的前面部分存储命名空间,后面部分的内容存储 ID,通常使用 : 来进行分隔。例如下面的 HASH 的键名为 article:92617,其中 article 为命名空间,ID 为 92617。

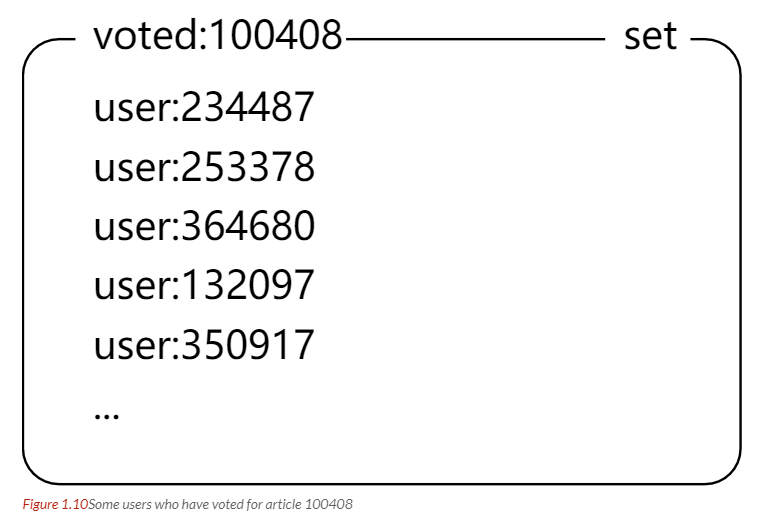

## 点赞功能

当有用户为一篇文章点赞时,除了要对该文章的 votes 字段进行加 1 操作,还必须记录该用户已经对该文章进行了点赞,防止用户点赞次数超过 1。可以建立文章的已投票用户集合来进行记录。

为了节约内存,规定一篇文章发布满一周之后,就不能再对它进行投票,而文章的已投票集合也会被删除,可以为文章的已投票集合设置一个一周的过期时间就能实现这个规定。

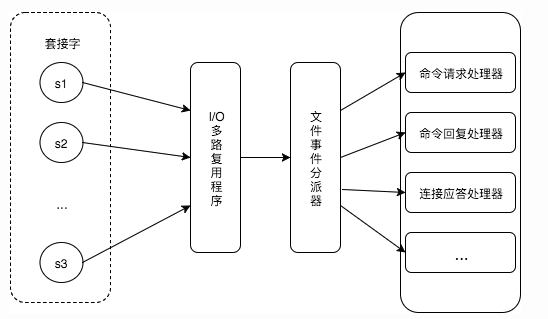

## 对文章进行排序

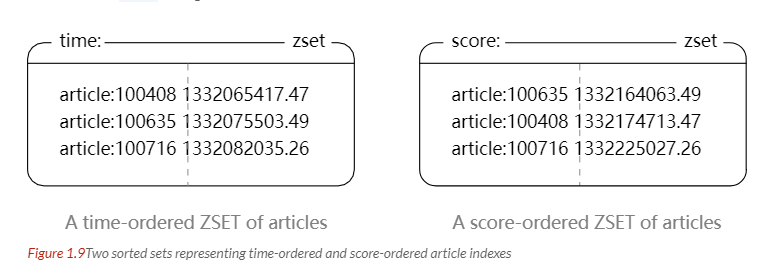

为了按发布时间和点赞数进行排序,可以建立一个文章发布时间的有序集合和一个文章点赞数的有序集合。(下图中的 score 就是这里所说的点赞数;下面所示的有序集合分值并不直接是时间和点赞数,而是根据时间和点赞数间接计算出来的)

# 参考资料

- Carlson J L. Redis in Action[J]. Media.johnwiley.com.au, 2013.

- 黄健宏. Redis 设计与实现 [M]. 机械工业出版社, 2014.

- REDIS IN ACTION

- Skip Lists: Done Right

- 论述 Redis 和 Memcached 的差异

- Redis 3.0 中文版- 分片

- Redis 应用场景

- Using Redis as an LRU cache

更多精彩内容将发布在公众号 CyC2018,公众号提供了该项目的离线阅读版本,后台回复”下载” 即可领取。也提供了一份技术面试复习思维导图,不仅系统整理了面试知识点,而且标注了各个知识点的重要程度,从而帮你理清多而杂的面试知识点,后台回复”资料” 即可领取。我基本是按照这个思维导图来进行复习的,对我拿到了 BAT 头条等 Offer 起到很大的帮助。你们完全可以和我一样根据思维导图上列的知识点来进行复习,就不用看很多不重要的内容,也可以知道哪些内容很重要从而多安排一些复习时间。

数据库/MySQL

本文字数: 8.1k 阅读时长 ≈ 7 分钟

一、索引#

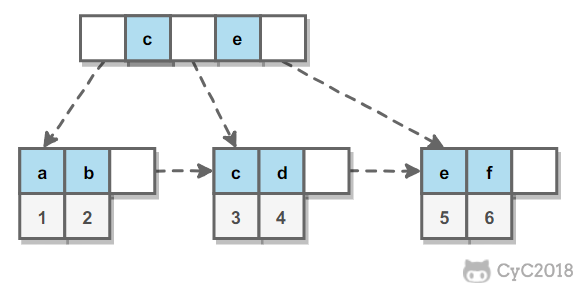

B+ Tree 原理#

数据库索引是存储在磁盘上的,当数据量大时,不能一次性把所有索引加载到内存中,只能逐一加载磁盘项(对应索引树的节点)。因此为了加快索引速度,需要减少磁盘IO次数,也就是降低数的高度。而B树的特征就是矮胖,适合用于构建索引。

1. B树#

B 树的特征:

- 关键字分布在整棵树中

- 任何一个关键字只出现在一个节点中

- 搜索有可能在叶子节点结束

- 所有叶子节点的高度相同

B树的详细介绍,请见数据结构笔记。

2. B+树#

B+树 是基于B树的改进版。与B树最大的区别是,B树中所有节点都会存储数据地址(即每个节点既有关键字也有关键字对应的数据信息),而在B+树中,所有数据地址都只存在于叶子节点中。所有叶节点相连。

在B+树中会保存两个头指针,一个指向根节点,用于索引。另一个指向关键字最小的叶子节点,用于遍历。

在 B+ Tree 中,一个节点中的 key 从左到右非递减排列,如果某个指针的左右相邻 key 分别是 keyi 和 keyi+1,且不为 null,则该指针指向节点的所有 key 大于等于 keyi 且小于等于 keyi+1。

### 3. B+树相比B树的优势 (1)B+树的空间利用率更高,减少IO次数:索引节点不存储数据信息,因此一次性能够读入更多的关键字。 (2)增删文件效率更高,叶子节点存储数据,且使用有序列表相连,范围查询更加方便。 (3)B+树的查询效率更加稳定,所有关键字的查询路径长度相同。

4. 与红黑树比较#

红黑树也可以用于索引,但是文件系统和数据可系统等普遍采用B+树进行索引,因为磁盘IO才是决定效率最大的因素,因此采用B+树这种矮胖的树更好。

5. B+树索引与hash索引的比较#

等值查询hash索引有绝对的优势,因为只需一次算法就能查找到键值。但是hash索引不支持范围查询。通过hash索引你也无法完成排序。

B+树索引支持范围查询,查询效率比较到平均。同时hash索引在有大量重复键值时,效率也很低,因为会发生哈希碰撞问题。

例如对性别关键字使用hash索引就非常不合理。

MySQL 索引#

索引是在存储引擎层实现的,而不是在服务器层实现的,所以不同存储引擎具有不同的索引类型和实现。

1. B+Tree 索引#

是大多数 MySQL 存储引擎的默认索引类型。

因为不再需要进行全表扫描,只需要对树进行搜索即可,所以查找速度快很多。

因为 B+ Tree 的有序性,所以除了用于查找,还可以用于排序和分组。

可以指定多个列作为索引列,多个索引列共同组成键。

适用于全键值、键值范围和键前缀查找,其中键前缀查找只适用于最左前缀查找。如果不是按照索引列的顺序进行查找,则无法使用索引。

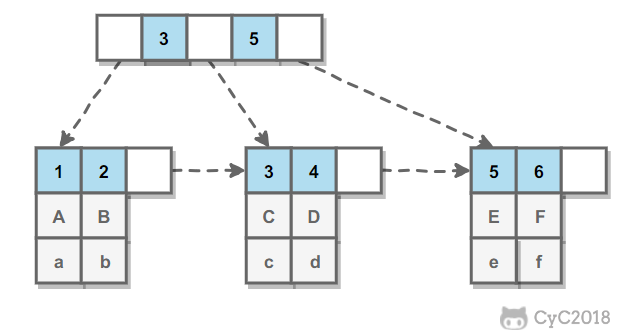

InnoDB 的 B+Tree 索引分为主索引和辅助索引。主索引的叶子节点 data 域记录着完整的数据记录,这种索引方式被称为聚簇索引。因为无法把数据行存放在两个不同的地方,所以一个表只能有一个聚簇索引。

辅助索引的叶子节点的 data 域记录着主键的值,因此在使用辅助索引进行查找时,需要先查找到主键值,然后再到主索引中进行查找。

### 2. 哈希索引

哈希索引能以 O(1) 时间进行查找,但是失去了有序性:

- 无法用于排序与分组;

- 只支持精确查找,无法用于部分查找和范围查找。

InnoDB 存储引擎有一个特殊的功能叫“自适应哈希索引”,当某个索引值被使用的非常频繁时,会在 B+Tree 索引之上再创建一个哈希索引,这样就让 B+Tree 索引具有哈希索引的一些优点,比如快速的哈希查找。

3. 全文索引#

MyISAM 存储引擎支持全文索引,用于查找文本中的关键词,而不是直接比较是否相等。

查找条件使用 MATCH AGAINST,而不是普通的 WHERE。

全文索引使用倒排索引实现,它记录着关键词到其所在文档的映射。

InnoDB 存储引擎在 MySQL 5.6.4 版本中也开始支持全文索引。

4. 空间数据索引#

MyISAM 存储引擎支持空间数据索引(R-Tree),可以用于地理数据存储。空间数据索引会从所有维度来索引数据,可以有效地使用任意维度来进行组合查询。

必须使用 GIS 相关的函数来维护数据。

聚集索引和非聚集索引(物理角度分析)#

聚集索引只能存在一个,主键建立聚集索引,叶子节点存放数据页的位置。

非聚集索引中不存放数据位置,而是存放对应的主键。得到主键之后还需要在聚集索引上再查询一次。

索引的优点#

大大减少了服务器需要扫描的数据行数。

帮助服务器避免进行排序和分组,以及避免创建临时表(B+Tree 索引是有序的,可以用于 ORDER BY 和 GROUP BY 操作。临时表主要是在排序和分组过程中创建,不需要排序和分组,也就不需要创建临时表)。

将随机 I/O 变为顺序 I/O(B+Tree 索引是有序的,会将相邻的数据都存储在一起)。

索引的使用条件#

对于非常小的表、大部分情况下简单的全表扫描比建立索引更高效;

对于中到大型的表,索引就非常有效;

但是对于特大型的表,建立和维护索引的代价将会随之增长。这种情况下,需要用到一种技术可以直接区分出需要查询的一组数据,而不是一条记录一条记录地匹配,例如可以使用分区技术。

索引优化#

1. 独立的列#

在进行查询时,索引列不能是表达式的一部分,也不能是函数的参数,否则无法使用索引。

例如下面的查询不能使用 actor_id 列的索引:

1 | SELECT actor_id FROM sakila.actor WHERE actor_id + 1 = 5; |

2. 多列索引#

在需要使用多个列作为条件进行查询时,使用多列索引比使用多个单列索引性能更好。例如下面的语句中,最好把 actor_id 和 film_id 设置为多列索引。

1 | SELECT film_id, actor_ id FROM sakila.film_actor |

3. 索引列的顺序#

让选择性最强的索引列放在前面。

索引的选择性是指:不重复的索引值和记录总数的比值。最大值为 1,此时每个记录都有唯一的索引与其对应。选择性越高,每个记录的区分度越高,查询效率也越高。

例如下面显示的结果中 customer_id 的选择性比 staff_id 更高,因此最好把 customer_id 列放在多列索引的前面。

1 | SELECT COUNT(DISTINCT staff_id)/COUNT(*) AS staff_id_selectivity, |

1 | staff_id_selectivity: 0.0001 |

4. 前缀索引#

对于 BLOB、TEXT 和 VARCHAR 类型的列,必须使用前缀索引,只索引开始的部分字符。

前缀长度的选取需要根据索引选择性来确定。

5. 覆盖索引#

索引包含所有需要查询的字段的值。

具有以下优点:

- 索引通常远小于数据行的大小,只读取索引能大大减少数据访问量。

- 一些存储引擎(例如 MyISAM)在内存中只缓存索引,而数据依赖于操作系统来缓存。因此,只访问索引可以不使用系统调用(通常比较费时)。

- 对于 InnoDB 引擎,若辅助索引能够覆盖查询,则无需访问主索引。

二、查询性能优化#

使用 Explain 进行分析#

Explain 用来分析 SELECT 查询语句,开发人员可以通过分析 Explain 结果来优化查询语句。

比较重要的字段有:

- select_type : 查询类型,有简单查询、联合查询、子查询等

- key : 使用的索引

- rows : 扫描的行数

优化数据访问#

1. 减少请求的数据量#

- 只返回必要的列:最好不要使用 SELECT * 语句。

- 只返回必要的行:使用 LIMIT 语句来限制返回的数据。

- 缓存重复查询的数据:使用缓存可以避免在数据库中进行查询,特别在要查询的数据经常被重复查询时,缓存带来的查询性能提升将会是非常明显的。

2. 减少服务器端扫描的行数#

最有效的方式是使用索引来覆盖查询。

重构查询方式#

1. 切分大查询#

一个大查询如果一次性执行的话,可能一次锁住很多数据、占满整个事务日志、耗尽系统资源、阻塞很多小的但重要的查询。

1 | DELETE FROM messages WHERE create < DATE_SUB(NOW(), INTERVAL 3 MONTH); |

1 | rows_affected = 0 |

2. 分解大连接查询#

将一个大连接查询分解成对每一个表进行一次单表查询,然后在应用程序中进行关联,这样做的好处有:

- 让缓存更高效。对于连接查询,如果其中一个表发生变化,那么整个查询缓存就无法使用。而分解后的多个查询,即使其中一个表发生变化,对其它表的查询缓存依然可以使用。

- 分解成多个单表查询,这些单表查询的缓存结果更可能被其它查询使用到,从而减少冗余记录的查询。

- 减少锁竞争;

- 在应用层进行连接,可以更容易对数据库进行拆分,从而更容易做到高性能和可伸缩。

- 查询本身效率也可能会有所提升。例如下面的例子中,使用 IN() 代替连接查询,可以让 MySQL 按照 ID 顺序进行查询,这可能比随机的连接要更高效。

1 | SELECT * FROM tab |

1 | SELECT * FROM tag WHERE tag='mysql'; |

三、存储引擎#

InnoDB#

是 MySQL 默认的事务型存储引擎,只有在需要它不支持的特性时,才考虑使用其它存储引擎。

实现了四个标准的隔离级别,默认级别是可重复读(REPEATABLE READ)。在可重复读隔离级别下,通过多版本并发控制(MVCC)+ 间隙锁(Next-Key Locking)防止幻影读。

主索引是聚簇索引,在索引中保存了数据,从而避免直接读取磁盘,因此对查询性能有很大的提升。

内部做了很多优化,包括从磁盘读取数据时采用的可预测性读、能够加快读操作并且自动创建的自适应哈希索引、能够加速插入操作的插入缓冲区等。

支持真正的在线热备份。其它存储引擎不支持在线热备份,要获取一致性视图需要停止对所有表的写入,而在读写混合场景中,停止写入可能也意味着停止读取。

MyISAM#

设计简单,数据以紧密格式存储。对于只读数据,或者表比较小、可以容忍修复操作,则依然可以使用它。

提供了大量的特性,包括压缩表、空间数据索引等。

不支持事务。

不支持行级锁,只能对整张表加锁,读取时会对需要读到的所有表加共享锁,写入时则对表加排它锁。但在表有读取操作的同时,也可以往表中插入新的记录,这被称为并发插入(CONCURRENT INSERT)。

可以手工或者自动执行检查和修复操作,但是和事务恢复以及崩溃恢复不同,可能导致一些数据丢失,而且修复操作是非常慢的。

如果指定了 DELAY_KEY_WRITE 选项,在每次修改执行完成时,不会立即将修改的索引数据写入磁盘,而是会写到内存中的键缓冲区,只有在清理键缓冲区或者关闭表的时候才会将对应的索引块写入磁盘。这种方式可以极大的提升写入性能,但是在数据库或者主机崩溃时会造成索引损坏,需要执行修复操作。

比较#

事务:InnoDB 是事务型的,可以使用 Commit 和 Rollback 语句。

并发:MyISAM 只支持表级锁,而 InnoDB 还支持行级锁。

外键:InnoDB 支持外键。

备份:InnoDB 支持在线热备份。

崩溃恢复:MyISAM 崩溃后发生损坏的概率比 InnoDB 高很多,而且恢复的速度也更慢。

其它特性:MyISAM 支持压缩表和空间数据索引。

四、数据类型#

整型#

TINYINT, SMALLINT, MEDIUMINT, INT, BIGINT 分别使用 8, 16, 24, 32, 64 位存储空间,一般情况下越小的列越好。

INT(11) 中的数字只是规定了交互工具显示字符的个数,对于存储和计算来说是没有意义的。

浮点数#

FLOAT 和 DOUBLE 为浮点类型,DECIMAL 为高精度小数类型。CPU 原生支持浮点运算,但是不支持 DECIMAl 类型的计算,因此 DECIMAL 的计算比浮点类型需要更高的代价。

FLOAT、DOUBLE 和 DECIMAL 都可以指定列宽,例如 DECIMAL(18, 9) 表示总共 18 位,取 9 位存储小数部分,剩下 9 位存储整数部分。

字符串#

主要有 CHAR 和 VARCHAR 两种类型,一种是定长的,一种是变长的。

VARCHAR 这种变长类型能够节省空间,因为只需要存储必要的内容。但是在执行 UPDATE 时可能会使行变得比原来长,当超出一个页所能容纳的大小时,就要执行额外的操作。MyISAM 会将行拆成不同的片段存储,而 InnoDB 则需要分裂页来使行放进页内。

在进行存储和检索时,会保留 VARCHAR 末尾的空格,而会删除 CHAR 末尾的空格。

时间和日期#

MySQL 提供了两种相似的日期时间类型:DATETIME 和 TIMESTAMP。

1. DATETIME#

能够保存从 1000 年到 9999 年的日期和时间,精度为秒,使用 8 字节的存储空间。

它与时区无关。

默认情况下,MySQL 以一种可排序的、无歧义的格式显示 DATETIME 值,例如“2008-01-16 22:37:08”,这是 ANSI 标准定义的日期和时间表示方法。

2. TIMESTAMP#

和 UNIX 时间戳相同,保存从 1970 年 1 月 1 日午夜(格林威治时间)以来的秒数,使用 4 个字节,只能表示从 1970 年到 2038 年。

它和时区有关,也就是说一个时间戳在不同的时区所代表的具体时间是不同的。

MySQL 提供了 FROM_UNIXTIME() 函数把 UNIX 时间戳转换为日期,并提供了 UNIX_TIMESTAMP() 函数把日期转换为 UNIX 时间戳。

默认情况下,如果插入时没有指定 TIMESTAMP 列的值,会将这个值设置为当前时间。

应该尽量使用 TIMESTAMP,因为它比 DATETIME 空间效率更高。

五、分库分表#

1、随着单库中的数据量越来越大,相应的,查询所需要的时间也越来越多,这个时候,相当于数据的处理遇到了瓶颈

2、单库发生意外的时候,需要修复的是所有的数据,而多库中的一个库发生意外的时候,只需要修复一个库(当然,也可以用物理分区的方式处理这种问题)

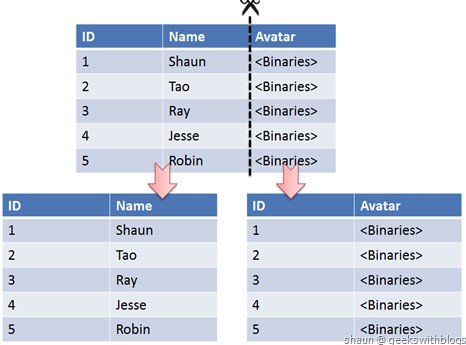

垂直切分#

垂直切分是将一张表按列切分成多个表,通常是按照列的关系密集程度进行切分,也可以利用垂直切分将经常被使用的列和不经常被使用的列切分到不同的表中。

在数据库的层面使用垂直切分将按数据库中表的密集程度部署到不同的库中,例如将原来的电商数据库垂直切分成商品数据库、用户数据库等。

## 水平切分

水平切分又称为 Sharding,它是将同一个表中的记录拆分到多个结构相同的表中。

当一个表的数据不断增多时,Sharding 是必然的选择,它可以将数据分布到集群的不同节点上,从而缓存单个数据库的压力。

水平切分策略#

- 哈希取模:hash(key) % N;

- 范围:可以是 ID 范围也可以是时间范围;

- 映射表:使用单独的一个数据库来存储映射关系。

Sharding 存在的问题#

1. 事务问题#

使用分布式事务来解决,比如 XA 接口。

2. 连接#

可以将原来的连接分解成多个单表查询,然后在用户程序中进行连接。

3. ID 唯一性#

保证ID全局唯一性,主要包括两个要求:

1)全局唯一性:不能出现重复的ID号。

2)数据递增:保证下一ID号一定大于上一个ID号。

- 使用全局唯一 ID(UUID,GUID是UUID的一种实现): 使用uuid作为主键是最简单的方案,缺点也很明显,uuid长度太长,占据的空间比较大,作为索引并且基于索引的查询性能上面会有一定的影响。

- 为每个分片指定一个 ID 范围

- 分布式 ID 生成器 (如 Twitter 的 Snowflake 算法):其主要算法的核心就是生成long型的ID,共64位,第一位未使用,41bit的毫秒级时间,5bitdatacenter标志位,5bit机器码,12bit作为毫秒内序列号。该算法每秒能产生26万个id

六、复制#

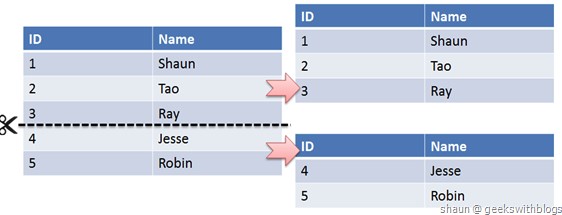

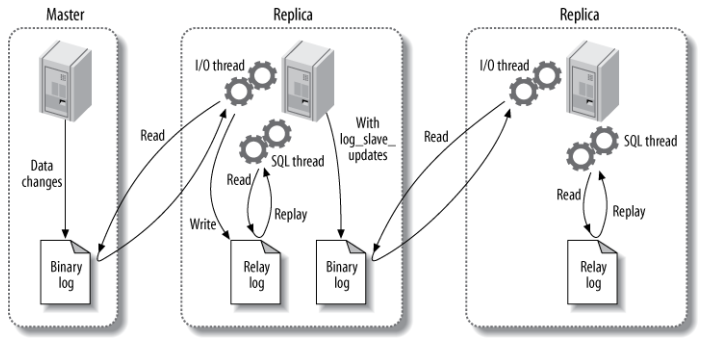

主从复制#

主要涉及三个线程:binlog 线程、I/O 线程和 SQL 线程。

- binlog 线程 :负责将主服务器上的数据更改写入二进制日志(Binary log)中。

- I/O 线程 :负责从主服务器上读取二进制日志,并写入从服务器的中继日志(Relay log)。

- SQL 线程 :负责读取中继日志,解析出主服务器已经执行的数据更改并在从服务器中重放(Replay)。

## 读写分离

主服务器处理写操作以及实时性要求比较高的读操作,而从服务器处理读操作。

读写分离能提高性能的原因在于:

- 主从服务器负责各自的读和写,极大程度缓解了锁的争用;

- 从服务器可以使用 MyISAM,提升查询性能以及节约系统开销;

- 增加冗余,提高可用性。

读写分离常用代理方式来实现,代理服务器接收应用层传来的读写请求,然后决定转发到哪个服务器。

# 七、备份 冷备份(停机备份) 冷备份发生在数据库已经关闭的情况下,数据库关闭之后会提供一个完整的数据库,只需要将关键的文件拷贝到另一个位置上。对于数据库来说冷备份是最快和最安全的方法。

冷备份优点:

- 速度快,只需拷贝文件

- 容易归档

- 容易恢复

- 低度维护,高度安全

冷备份的缺点:

- 单独使用时,只提供”某一时间点”的恢复

- 冷备份过程中,数据库不能工作

- 若磁盘空间有限,拷贝到其他外部存储设备,速度会很慢

- 不能按表,按用户进行恢复

热备份:

热备份是指在数据库运行时,备份数据库的sql语句,当数据库发生问题时,重新执行一遍备份的sql语句。

优点:

- 可以在表空间和数据文件级备份,备份时间短

- 备份时数据库可用

- 可以达到秒级恢复(精确恢复到某一时间点上)

- 可以对所有数据库实体进行恢复

- 大多数情况下,可以在数据库工作时进行回复

缺点:

- 备份不能出错,否则后果严重

- 难以维护,不允许以失败而告终

- 热备份不成功的话,结果用于恢复

参考资料#

- BaronScbwartz, PeterZaitsev, VadimTkacbenko, 等. 高性能 MySQL[M]. 电子工业出版社, 2013.

- 姜承尧. MySQL 技术内幕: InnoDB 存储引擎 [M]. 机械工业出版社, 2011.

- 20+ 条 MySQL 性能优化的最佳经验

- 服务端指南 数据存储篇 | MySQL(09) 分库与分表带来的分布式困境与应对之策

- How to create unique row ID in sharded databases?

- SQL Azure Federation – Introduction

- MySQL 索引背后的数据结构及算法原理

- MySQL 性能优化神器 Explain 使用分析

- How Sharding Works

- 大众点评订单系统分库分表实践

- B + 树

更多精彩内容将发布在公众号 CyC2018,公众号提供了该项目的离线阅读版本,后台回复”下载” 即可领取。也提供了一份技术面试复习思维导图,不仅系统整理了面试知识点,而且标注了各个知识点的重要程度,从而帮你理清多而杂的面试知识点,后台回复”资料” 即可领取。我基本是按照这个思维导图来进行复习的,对我拿到了 BAT 头条等 Offer 起到很大的帮助。你们完全可以和我一样根据思维导图上列的知识点来进行复习,就不用看很多不重要的内容,也可以知道哪些内容很重要从而多安排一些复习时间。

Java_IO

Java中的IO总结

Java_HashMap

Java中HashMap的原理

Java_内部类

Java中的内部类总结

Java_IO模型

IO模型

Java_String

Java中String总结

Java_基础

Java基础语法,以及常见面试考点